La investigación científica de 2 chilenos fue publicada en Nature.com. Pese a que inicialmente se obtuvo un 96,19% de exactitud en los diagnósticos por rayos X, se detectó que éstos no consideraron características de los pacientes tales como género, edad, distribución de los pacientes y características demográficas, lo que en una estructura de datos mayor, conduciría a errores en los resultados.

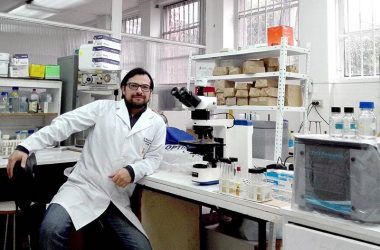

Según el estudio “Sesgos asociados a la estructura de base de datos para la detección de COVID-19 mediante rayos X”, realizado por Reinel Tabares, cientista de datos e investigador postdoctoral, junto al profesor de la Facultad de Ingeniería y Ciencias de la Universidad Adolfo Ibáñez (UAI), Gonzalo Ruz, el machine learning – o aprendizaje automático – no consideró las características de los pacientes en el diagnóstico de COVID-19 mediante rayos X de tórax, uno de los métodos utilizados para la detección temprana, debido a sesgos en las bases de datos utilizadas.

El estudio descubrió que había datos muy heterogéneos y no estructurados: información incompleta de pacientes, distintas condiciones y tecnologías presentes durante la obtención de las radiografías, desbalance de clases y mezcla descuidada de múltiples conjuntos de datos.

“En este caso, dada la contingencia de la pandemia, hubo mucho apuro en agarrar bases de datos sin tener mucho ojo y empezar a entrenar modelos. A modo de ejemplo, en estas bases juntaban datos de radiografías captadas con una máquina y luego imágenes capturadas con otra máquina y eso generaba imágenes de diferente calidad”, resaltó Ruz.

“Esta investigación, que inicialmente buscaba probar la efectividad del diagnóstico, la integramos al trabajo que estamos realizando en la UAI para el proyecto Algoritmos Éticos, Responsables y Transparentes y comenzamos, adicionalmente, a analizar las bases de datos con una perspectiva de equidad y responsabilidad, entre otros principios”, explicó Tabares.

En la investigación se analizaron 19 bases de datos de detección de COVID-19 mediante rayos X de tórax en los que, pese a que cuando se verificó la información de una de las bases de datos más populares, se obtuvo un 96,19% de exactitud, se detectó que los diagnósticos no consideraron las características de los pacientes en las radiografías, tales como género, edad, distribución de los pacientes y características demográficas, lo que en una estructura de datos mayor, conduciría a errores en los resultados.

“Uno puede tener un modelo (de datos) de solo pacientes mayores y después usarlo para diagnosticar a niños, pero eso requiere que tu base ya esté entrenada acordemente”, dijo Ruz.

Para verificar esta información se usó Aequitas, una herramienta ética de auditoría de sesgos de información de machine learning que permite tomar decisiones informadas para desarrollar y desplegar herramientas de evaluación predictiva de riesgos y, con ello, formas de mitigarlos.

“Hoy en día, incluso en llamados para desarrollo de tecnología, hay conciencia de esto y dentro de las bases de los concursos o licitaciones están incorporando exigencias para que los datos con los cuales se entrenan cumplan con ciertos estándares éticos y de manejo de sesgos”, indicó Ruz.

Si bien el estudio se utilizó para analizar los diagnósticos de COVID-19 mediante machine learning, los resultados y aprendizajes se pueden extrapolar a cualquier área de investigación.

“Es indispensable considerar este tipo de análisis profundo de los datos y sus metadatos, también realizar un examen visual de la información en el caso de que el tipo de datos utilizados sean imágenes, con el objetivo de detectar tempranamente posibles sesgos y tratar de mitigarlos, para así obtener resultados con estándares éticos y responsables, en especial si estamos abordando un tema tan delicado de salud como es el COVID-19”, concluyó Tabares.

El proyecto Algoritmos Éticos, Responsables y Transparentes es una iniciativa inédita en Chile, que ejecuta la UAI con financiamiento de BID Lab (el laboratorio de innovación del Grupo BID) y en alianza con socios del mundo público y privado. Su objetivo es instalar capacidades y estándares para incorporar consideraciones éticas en la compra y utilización de inteligencia artificial y algoritmos de decisión automatizada en agencias estatales, y en la formulación y desarrollo de estas soluciones por parte de los proveedores tecnológicos.